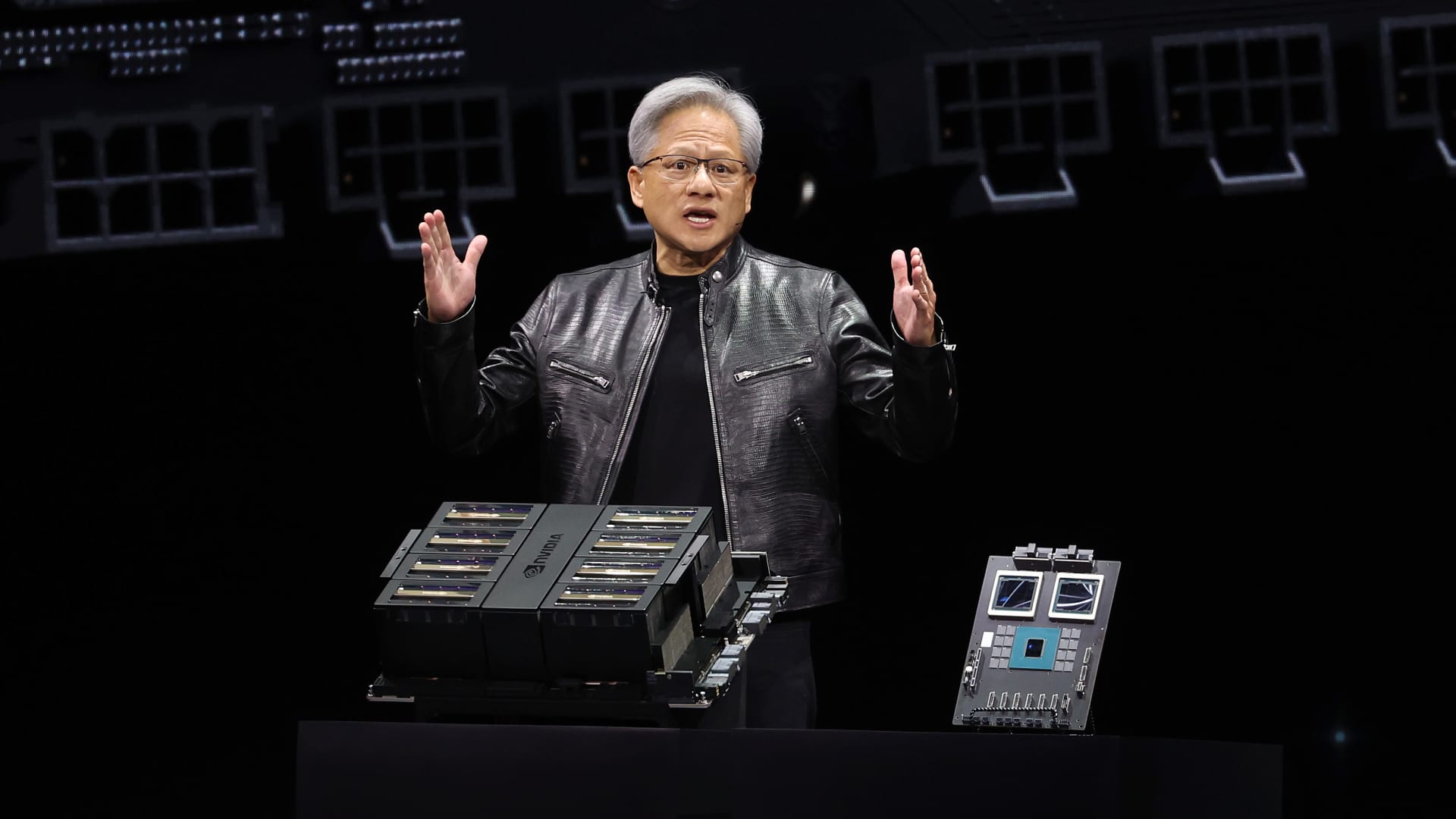

CEO Nvidia Jensen Huang memberikan pidato utama selama Konferensi Kecerdasan Buatan Nvidia GTC di SAP Center pada 18 Maret 2024 di San Jose, California.

Justin Sullivan | Getty Images

Nvidia pada hari Senin mengumumkan generasi baru chip kecerdasan buatan dan perangkat lunak untuk menjalankan model kecerdasan buatan. Pengumuman tersebut, yang dibuat selama konferensi pengembang Nvidia di San Jose, datang saat perusahaan chip tersebut berusaha untuk memperkuat posisinya sebagai pemasok utama bagi perusahaan kecerdasan buatan.

Harga saham Nvidia naik lima kali lipat dan penjualan total telah lebih dari tiga kali lipat sejak ChatGPT OpenAI memulai ledakan kecerdasan buatan pada akhir 2022. GPU server high-end Nvidia penting untuk pelatihan dan penyebaran model kecerdasan buatan yang besar. Perusahaan seperti Microsoft dan Meta telah menghabiskan miliaran dolar untuk membeli chip tersebut.

Generasi baru prosesor grafis kecerdasan buatan dinamai Blackwell. Chip Blackwell pertama disebut GB200 dan akan dikirimkan tahun ini. Nvidia memikat pelanggannya dengan chip yang lebih kuat untuk mendorong pemesanan baru. Perusahaan dan pembuat perangkat lunak, misalnya, masih berusaha keras untuk mendapatkan generasi saat ini dari Hopper H100 dan chip serupa.

\”Hopper fantastis, tetapi kita memerlukan GPU yang lebih besar,\” kata CEO Nvidia Jensen Huang pada hari Senin dalam konferensi pengembang perusahaan di California.

Saham Nvidia turun lebih dari 1% dalam perdagangan diperpanjang pada hari Senin.

Perusahaan juga memperkenalkan perangkat lunak yang menghasilkan pendapatan bernama NIM yang akan memudahkan penyebaran kecerdasan buatan, memberikan pelanggan alasan lain untuk tetap menggunakan chip Nvidia daripada pesaing yang semakin berkembang.

Pihak eksekutif Nvidia mengatakan bahwa perusahaan semakin sedikit menjadi penyedia chip mercenary dan lebih menjadi penyedia platform, seperti Microsoft atau Apple, di mana perusahaan lain dapat membangun perangkat lunak.

\”Blackwell bukanlah chip, itu adalah nama platform,\” kata Huang.

\”Produk komersial yang dapat dijual adalah GPU dan perangkat lunak semuanya untuk membantu orang menggunakan GPU dengan cara yang berbeda,\” kata Manuvir Das, VP perusahaan Nvidia dalam sebuah wawancara. \”Tentu, kami masih melakukannya. Tetapi yang benar-benar berubah adalah, kami benar-benar memiliki bisnis perangkat lunak komersial sekarang.\”

Das mengatakan perangkat lunak baru Nvidia akan memudahkan menjalankan program-program pada semua GPU Nvidia, bahkan yang lebih lama yang mungkin lebih cocok untuk penyebaran tetapi bukan untuk membangun kecerdasan buatan.

\”Jika Anda seorang pengembang, Anda memiliki model menarik yang ingin Anda ajukan, jika Anda masukkannya ke dalam NIM, kami akan memastikan bahwa program tersebut dapat dijalankan pada semua GPU kami, sehingga Anda mencapai banyak orang,\” kata Das.

Bertemu Blackwell, penerus Hopper

Superchip Grace Blackwell GB200 Nvidia, dengan dua prosesor grafis B200 dan satu prosesor pusat berbasis Arm.

Setiap dua tahun Nvidia memperbarui arsitektur GPU-nya, membuka lonjakan besar dalam kinerja. Banyak model kecerdasan buatan yang dirilis dalam setahun terakhir dilatih pada arsitektur Hopper perusahaan – digunakan oleh chip seperti H100 – yang diumumkan pada tahun 2022.

Nvidia mengatakan prosesor berbasis Blackwell, seperti GB200, menawarkan peningkatan kinerja yang besar bagi perusahaan kecerdasan buatan, dengan 20 petaflops dalam kinerja kecerdasan buatan dibandingkan dengan 4 petaflops untuk H100. Daya pemrosesan tambahan akan memungkinkan perusahaan kecerdasan buatan untuk melatih model yang lebih besar dan lebih rumit, kata Nvidia.

Chip ini termasuk apa yang Nvidia sebut sebagai \”mesin transformer yang dibangun khusus untuk menjalankan kecerdasan buatan berbasis transformer, salah satu teknologi inti yang mendasari ChatGPT.\”

GPU Blackwell besar dan menggabungkan dua die yang dibuat secara terpisah menjadi satu chip yang diproduksi oleh TSMC. Chip ini juga akan tersedia sebagai seluruh server yang disebut GB200 NVLink 2, yang menggabungkan 72 GPU Blackwell dan bagian Nvidia lainnya yang dirancang untuk melatih model kecerdasan buatan.

CEO Nvidia Jensen Huang membandingkan ukuran chip baru \”Blackwell\” versus chip \”Hopper\” H100 saat konferensi pengembang perusahaan, di San Jose, California.

Amazon, Google, Microsoft, dan Oracle akan menjual akses ke GB200 melalui layanan cloud. GB200 memasangkan dua GPU Blackwell B200 dengan satu CPU Grace berbasis Arm. Nvidia mengatakan Amazon Web Services akan membangun klaster server dengan 20.000 chip GB200.

Nvidia mengatakan sistem tersebut dapat mendeploy model dengan 27 triliun parameter. Itu jauh lebih besar dari model terbesar, seperti GPT-4, yang dilaporkan memiliki 1,7 triliun parameter. Banyak peneliti kecerdasan buatan percaya bahwa model-model yang lebih besar dengan lebih banyak parameter dan data dapat membuka kemampuan baru.

Nvidia tidak memberikan biaya untuk GB200 baru atau sistem tempat ia digunakan. H100 berbasis Hopper Nvidia biaya antara $25.000 dan $40.000 per chip, dengan sistem keseluruhan yang biayanya hingga $200.000, menurut perkiraan analis.

Nvidia juga akan menjual prosesor grafis B200 sebagai bagian dari sistem lengkap yang memakan seluruh rak server.

Nvidia juga mengumumkan bahwa mereka menambahkan produk baru bernama NIM, yang merupakan singkatan dari Nvidia Inference Microservice, ke langganan perangkat lunak perusahaan Nvidia.

NIM memudahkan penggunaan GPU Nvidia lama untuk inferensi, atau proses menjalankan perangkat lunak kecerdasan buatan, dan akan memungkinkan perusahaan untuk terus menggunakan ratusan juta GPU Nvidia yang mereka miliki. Inferensi memerlukan daya komputasi yang lebih sedikit daripada pelatihan awal model kecerdasan buatan baru. NIM memungkinkan perusahaan yang ingin menjalankan model kecerdasan buatan mereka sendiri, daripada membeli akses ke hasil kecerdasan buatan sebagai layanan dari perusahaan seperti OpenAI.

Strateginya adalah mendapatkan pelanggan yang membeli server berbasis Nvidia untuk mendaftar ke perusahaan Nvidia, yang biayanya $4.500 per GPU per tahun untuk lisensi. Nvidia akan bekerja sama dengan perusahaan kecerdasan buatan seperti Microsoft atau Hugging Face untuk memastikan model kecerdasan buatan mereka disesuaikan untuk dijalankan pada semua chip Nvidia yang kompatibel. Kemudian, menggunakan NIM, pengembang dapat secara efisien menjalankan model tersebut pada server mereka sendiri atau server berbasis cloud Nvidia tanpa proses konfigurasi yang panjang.

\”Dalam kode saya, di mana saya memanggil OpenAI, saya akan mengganti satu baris kode untuk menunjukkannya ke NIM ini yang saya dapatkan dari Nvidia,\” kata Das.

Nvidia mengatakan perangkat lunak tersebut juga akan membantu kecerdasan buatan berjalan pada laptop yang dilengkapi dengan GPU, bukan pada server di cloud.